GPT-5.3-Codex 来了!OpenAI 新一代编程 AI 速度提升 25%

OpenAI 宣布推出 GPT-5.3-Codex,称其为目前最强大的编程专用智能体 AI 模型。据公司介绍,新模型在 SWE-bench Pro 和 Terminal-Bench 等权威基准测试中创下新纪录,运行速度也比上一代 GPT-5.2-Codex 快约 25%。

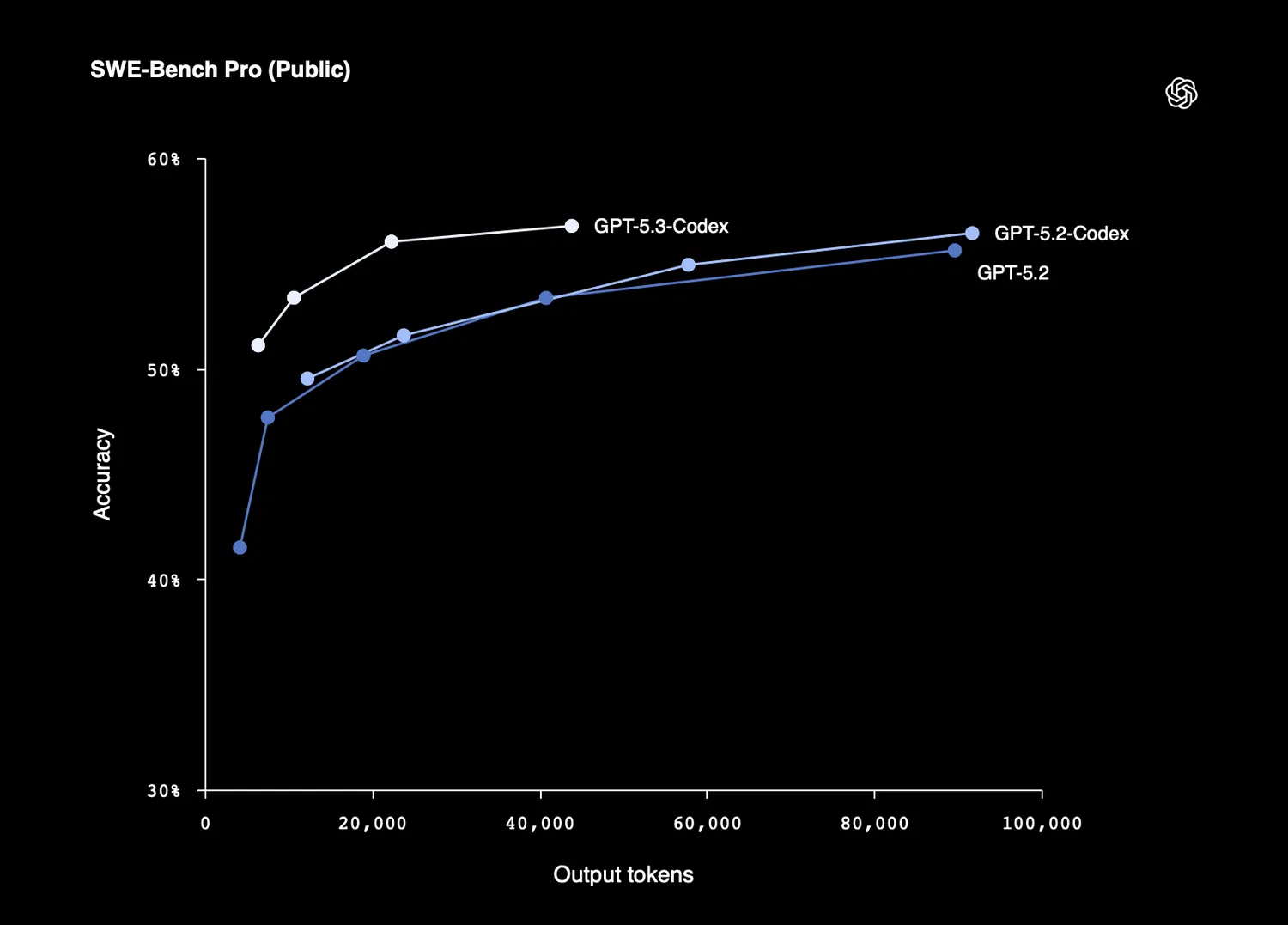

Codex 系列模型主要面向开发者群体。在公开的 SWE-bench Pro 测试中,GPT-5.3-Codex 取得 56.8% 的成绩,略高于 GPT-5.2-Codex 的 56.4% 和 GPT-5.2 的 55.6%。在 Terminal-Bench 2.0 基准测试中,新模型得分高达 77.3%,显著优于 GPT-5.2-Codex(64.0%)和 GPT-5.2(62.2%)。

而在评估 AI 与计算机交互能力的 OSWorld-Verified 智能体测试中,GPT-5.3-Codex 得分为 64.7%,远超 GPT-5.2-Codex(38.2%)和 GPT-5.2(37.9%)。

OpenAI 还指出,GPT-5.3-Codex 在取得上述优异成绩的同时,所消耗的 token 数量反而少于早期 Codex 模型。得益于推理(inference)堆栈的优化,该模型在 Codex 应用中的响应速度提升了约四分之一。

OpenAI 强调,GPT-5.3-Codex 不仅是更强大的代码生成工具,更是开发者的“智能搭档”。用户可在任务执行过程中实时引导和调整模型行为,而不会丢失上下文。在 Codex 应用中,模型会持续汇报工作进展,使开发者能够随时提问、讨论实现方案,并实时引导 AI 走向理想解决方案。

此外,OpenAI 透露,GPT-5.3-Codex 的早期版本表现极为出色,甚至被用于优化后续版本的训练过程和部署支持。

公司在官方博客中如此描述 Codex 的演进历程:

“最初,我们希望打造一个更出色的编程智能体助手;如今,它已发展为一种通用的数字搭档 —— 能在计算机上自主工作,不仅拓展了能够参与创造的人群范围,也极大增强了 Codex 本身的能力边界。”

目前,GPT-5.3-Codex 已向所有 ChatGPT 付费订阅用户开放,支持通过 Codex 应用、命令行工具(CLI)、主流 IDE 插件以及网页界面使用。OpenAI 计划在不久的将来通过 API 提供访问支持。

OpenAI 还特别提到,GPT-5.3-Codex 的设计、训练与部署均基于 NVIDIA GB200 NVL72 系统。